勾配 消失 問題 と は

簡単 に 痩せる 方法 中学生【深層学習】勾配消失問題とは?ニューラルネットワーク学習 . 「 勾配消失問題とは、各層の勾配で小さい値が続いた場合、入力側付近の勾配はゼロと見なされてしまい、学習がうまく進まなくなってしまう問題 」のことを言います。 浅い層のニューラルネットワークを構築する上で、勾配消失問題が深刻になることはほとんどありません。 一方で、何層も多層化されたニューラルネットワークを構築する際はこの問題への対応が必要です。 活性化関数による勾配消失対策. 勾配消失問題を引き起こす原因の1つとして、 活性化関数 があります。 例えばシグモイド関数を利用した場合、勾配 [∂f (x)/∂x]を計算すると、最大値が0.25であると分かります。. 幸せ を 呼ぶ 画像

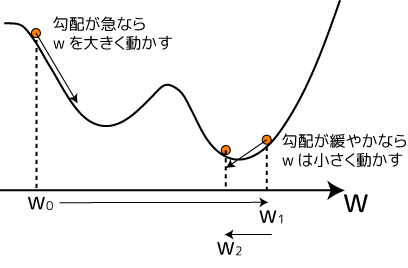

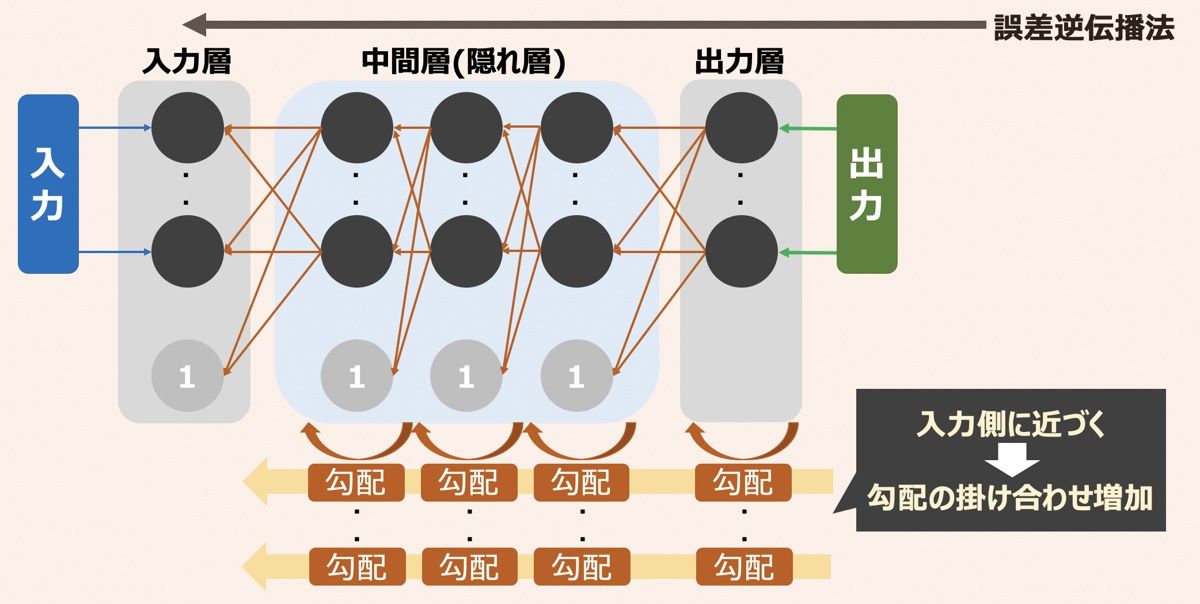

うずら 豆 の 育て 方【基礎から理解しよう】勾配消失問題と活性化関数を分かり . 勾配消失問題とは? そもそも勾配というのは、損失関数をニューラルネットワークのパラメータ(重み)で微分したものでした。 勾配消失問題というからには、まさにその勾配が消えてほぼゼロになってしまうことが問題になっているわけです。. 勾配消失問題 - Wikipedia. 勾配消失問題(こうばいしょうしつもんだい、英: vanishing gradient problem)は、機械学習において、勾配ベースの学習手法と誤差逆伝播法を利用してニューラルネットワークを学習する際に、誤差逆伝播に必要な勾配が非常に小さくなり [1]. 木村 哲 ぺるけ

チャレンジ キッズ おおたか の 森園 本園勾配消失問題と勾配爆発問題~原因と解決策~ | マサムネの部屋. 勾配消失の解決策として、シグモイドでなくて、relu関数を使うと良いと言われますが、本当か検証します。 また、勾配爆発問題が起こる状況を再現し、解決策を解説します。. 勾配消失問題 | Ai研究所. 勾配消失問題とは、機械学習手法のひとつであるニューラルネットワークの設計において、 勾配が消失することで学習が進まなくなる技術的な問題 のことです。. ディープラーニングの勾配消失問題徹底解説:原因から最新の . クッション フロア ワックス がけ

ヤシ の 木 根っこ勾配消失問題の原因. なぜ勾配消失問題はディープラーニングで問題となるのか. 活性化関数と勾配消失. 初期値の設定と勾配消失問題. 正則化と勾配消失問題. 勾配クリッピングの導入. 勾配消失問題を解決するモダンなアーキテクチャ. 勾配消失問題の実例とその対策. 勾配消失問題を避けるためのベストプラクティス. まとめ:勾配消失問題の理解と対策の重要性. はじめに:ディープラーニングと勾配消失問題. 近年、ディープラーニングは画像認識、自然言語処理、音声認識など、多くの領域で驚異的な進展を遂げています。 この技術の背後には、 大量のデータと複雑なニューラルネットワークが存在 します。 しかし、それらのネットワークを訓練する過程で、勾配消失問題という難敵が立ちはだかることがあります。. 深層学習(勾配消失問題~CNN) #DeepLearning - Qiita. 勾配消失問題. 誤差逆伝播法が下位層 (出力層から入力層)に向かって進んでいくにつれて、勾配がどんどん緩やかになっていく。 そのため、勾配降下法による更新では下位層のパラメータはほとんど変わらず、訓練は最適値に収束しなくなる。 勾配消失問題の一例として、シグモイド関数の微分を考える. シグモイド関数を微分した際、入力値が0のときに最大値を取る。 その値として正しいものは? f (u)= (1-sigmoid (u)) (sigmoid (u)). 第8回 さらにディープな世界へ: 勾配消失問題と残差 . この現象を 勾配消失問題 という。 上の問題を解決するために開発された 残差ネットワーク では、 入力と出力を直接つなぐ スキップ接続 によって 勾配が減衰するのを防いでいる。. 勾配消失問題 - 【AI・機械学習用語集】 - zero to one. 勾配消失問題とは、誤差逆伝播法の際に層が深いニューラルネットワークにおいて勾配がほぼ0になってしまい、学習が上手くいかなくなる問題です。 誤差逆伝播法では出力から入力に向かって勾配を乗算していきますが、この際勾配の値が小さくなるような活性化関数を用いていると勾配消失問題が発生しやすいことが知られています。 シグモイド関数のような勾配の最大値が0.25といった小さな値を持つ活性化関数が代表例です。 👉 より体系的に学びたい方は「 人工知能基礎 」(東京大学松尾豊先生監修)へ. クイズ. 以下の文章を読み,空欄 (ア)に最もよく当てはまる選択肢を1つ選べ.. 深層学習で必ず遭遇する勾配消失問題とその解決策とは? | Ai . 勾配消失問題は、深層学習において勾配が層を通過する際に、値が小さくなってしまい、学習が進まなくなる現象です。 この問題が発生する原因や、具体的な例、そしてその影響について説明します。 III. 勾配消失問題の解決策. 勾配消失問題に対する解決策として、重みの初期化方法や活性化関数の選択方法、バッチ正規化、勾配クリッピング、層の追加による解決策などがあります。 それぞれの解決策について、具体的な手法やその効果について解説します。 IV. 解決策の比較. 各解決策の特徴や効果、そして実装の難易度や計算コストなどを比較して、どの解決策が最も適しているかを考察します。 また、実際にどのような状況でどの解決策が有効かを検証するため、実験結果も紹介します。 V. まとめと今後の展望. 深層学習 Day 2 - Section 1 勾配消失問題 のまとめ - Qiita. 勾配消失問題. 定義. 誤差逆伝播法が下位層(入力層の側)に進んでいくにつれて、 勾配がどんどん緩やかになっていく。 そのため、勾配降下法による更新では下位層のパラメータはほとんど変わらず、 訓練は最適値に収束しなくなる。 原因. 例えばシグモイド関数の勾配の最大値は確認テストに記したように 0.25 である。 ある個所の重みの勾配を求めるときは連鎖率で微分値を掛け算するが、 シグモイド関数の勾配値(最大0.25)を掛けると、重みの勾配が小さくなってしまう。 中間層が複数のシグモイド関数で構成されていると、 それらのシグモイド関数を通るたびに重みの勾配が小さくなる。 解決法. 活性化関数の選択. 重みの初期値設定. バッチ正規化. 【解決法1】活性化関数の選択. 勾配消失問題とは?概要・影響・原因など | ストーンウェブ . まんまる 堂 セミナー

嫌い な cm 最新勾配消失問題は、ニューラルネットワークの学習において、重要な技術的課題とされています。この問題により、学習効果が低下し、性能が悪化することがあります。本記事では、勾配消失問題の定義や原因、対策方法について詳しく解説し. RNNの勾配消失・爆発についてまとめてみる #機械学習 - Qiita. これを逆伝播時に流れてくる勾配にかけていきます。 つまり時間を経るたび1より小さい数が乗算されていくため、勾配がだんだんと小さくなっていき消失してしまうわけです。 爆発の原因 先ほどの図をもう一度見てみましょう。. 【勾配消失と勾配爆発はなぜ起こるのか?】その原因と対策を . 勾配消失の原因をExcelで追跡する. 2.1. 勾配消失を再現する. 2.2. シグモイド関数の導関数がゼロになることが原因. 2.3. シグモイド関数の導関数がゼロになるのは入力が大きすぎるため. 2.4. 隠れ層が多いと勾配消失し易い. 2.5. 隠れ層が多い場合の対策はReLU関数. 3. 勾配爆発の原因をExcelで追跡する. 3.1. 勾配爆発を再現する. 3.2. 勾配爆発の原因. 3.3. 勾配爆発の対策には入力の正規化と初期値の設定の見直し. 4. Udemyの関連講座. Excelだと見える勾配消失と勾配爆発の原因. Excelでニューラルネットワークの実装を行うと、Pythonにあるような ライブラリー がないためとても手間がかかるのですが、利点もあります。. ニューラルネットワークと深層学習 - GitHub Pages. なぜ勾配消失問題が起きるのか: 勾配消失問題の要因を理解するために、勾配全体の式を書き出してみましょう。 begin{eqnarray} frac{partial C}{partial b_1} = sigma(z_1) , w_2 sigma(z_2) , w_3 sigma(z_3) , w_4 sigma(z_4) , frac{partial C}{partial a_4}. tag{122}end{eqnarray} 最後の . ニューラルネットワークの活性化関数ReLU関数を徹底解説 . ニューラルネットワークの活性化関数ReLU関数を徹底解説! |スタビジ. 当サイト【スタビジ】の本記事では、ディープラーニングの活性化関数としてよく用いられるReLU(Rectified Linear Unit)関数について解説していきます! ReLU関数の特徴について学び実際にPythonでReLU関数を使ったディープラーニングのモデルを高知きしていきましょう!. [Python] ReLU活性化関数の理解を深めよう - Zenn. 勾配消失問題は、誤差逆伝播法でのモデルの学習の際に途中のレイヤーで誤差が0に近い値を持つレイヤーがあるとパラメータへの補正値がほぼ0になってしまい学習が進まなくなる問題のこと。飽和問題は、モデルの推論時に優位な情報を. 完全ガイド:活性化関数の基本から最新動向までを徹底解説 . 勾配消失問題と活性化関数. 活性化関数との関連性. 最新の研究: 活性化関数の新しい動向. 適応的活性化関数. 深さに応じた活性化関数の選択. 自動機械学習 (AutoML) による活性化関数の探索. 活性化関数の実装方法. 勾配消失問題(こうばいしょうしつもんだい)とは? 意味 . 勾配消失問題(こうばいしょうしつもんだい)とは? 意味・読み方・使い方をわかりやすく解説 - goo国語辞書. 辞書. 国語辞書. 品詞. 名詞. 「勾配消失問題」の意味. 勾配消失問題( こうばいしょうしつもんだい ) とは? 意味・読み方・使い方. ブックマークへ登録. 意味. 例文. 慣用句. 画像. こうばいしょうしつ‐もんだい〔コウバイセウシツ‐〕【勾配消失問題】 の解説. 機械学習 の多層化した ニューラルネットワーク において、ある 段階 を越えると 学習 が進まなくなること。. 勾配分布のプロットによる深層ニューラル ネットワークの勾配 . 深いネットワークの学習では、 "勾配消失" の問題がよく発生します。 深層学習の学習アルゴリズムは、学習中にネットワークの学習可能なパラメーターを調整して損失を最小にすることを目的としています。 勾配ベースの学習アルゴリズムは、現在の学習可能なパラメーターについての損失関数の勾配を使用して調整レベルを決定します。 初期の層では、前の層から伝播された勾配を使用して勾配を計算します。 そのため、常に 1 未満の勾配値を生成する活性化関数がネットワークに含まれている場合、更新アルゴリズムが初期の層に移動するにつれて、勾配の値が次第に小さくなります。 その結果、ネットワークの初期の層はほとんど 0 に近い小さな勾配を受け取ることになり、ネットワークは学習ができなくなってしまいます。. 深層学習前編2 勾配消失問題~学習率最適化手法 講義課題 . 勾配消失問題とは誤差逆伝播法が下位層に進んでいくにつれて、勾配がどんどん緩やかになっていく問題。 つまり、下位層のパラメータを更新してもほとんど値が変わらず最適値に収束しなくなってしまう. 特にシグモイド関数を使っている場合に起きやすい。 その理由はシグモイド関数の微分は最大値が0.25であるためパラメータの更新値が必然的に小さくなってしまうからである. 勾配消失問題の解決法1 活性化関数の選択. ReLU関数を使用する (ReLU関数については活性化関数の項で説明済み) 勾配消失問題の解決法2 初期値の設定. ReLU関数、シグモイド関数、双曲線正接関数を使う場合にXavierという手法をつかって重みの初期値を設定すると勾配消失問題の解決につながる. 直感で理解するlstm・Gru入門 - 機械学習の基礎をマスター . 最も単純なRNNには、勾配消失問題と重み衝突という二つの理由により長期的な特徴の学習は苦手であるため、内部に記憶素子やゲート機構(Attentionに似た仕組み)を取り入れたLSTMやGRUなどが提案された。 LSTM: 長期的特徴と短期的特徴を学習することができる。 欠点は計算量が多いこと。 GRU: LSTMの代替となるモデルでLSTMより計算量が少なくてすむ。 性能はLSTMと変わらないとされている。 順伝播型ニューラルネットワーク(FNN) 順伝播型ニューラルネットワーク(Feedforward Neural Network: FNN)とは、生体の神経細胞を数理的にモデル化し、何層もスタックしたニューラルネットワークのことです。. ResNet | residue learning を取り入れて最大 152 層からなる . 勾配消失問題. 深い層を持つニューラルネットワークは、理論上、浅い層を持つニューラルネットワークに比べて高い性能を示すか、あるいは同等な性能を示す。 例えば、20 層のニューラルネットワークで十分に学習できデータを、56 層からなるニューラルネットワークに学習させたとき、パラメータが多い分だけより多くのことを学習できるはずである。 あるいは、21〜56 層目を恒等関数とすることで、56 層のニューラルネットワークは、見かけ上 10 層のニューラルネットワークと同等な性能を示すはずである。 VGGNet の論文で調べられたように、層を深くすることで確かに性能が良くなった。. Rnn(リカレントニューラルネットワーク)とは?基本概念から . RNNの仕組み. RNNは、「入力層」「隠れ層」「出力層」の3層で構成されているニューラルネットワークです。 入力層で入力された情報が隠れ層で演算され、その結果が出力層に出力していきその結果を再度隠れ層に入力し再演算を行います。 隠れ層が時系列予測を行うための大きな役割を持っており、 隠れ層があることによって過去の情報を保持した状態で新しい情報を適切に処理することが可能 です。 RNNは3層で構成されていますが、以上のように隠れ層が何度も何度も使用されることによって複数層のあるニューラルネットワークに見えます。 BPTTとは、「Backpropagation Through Time」という言葉の略称で、RNNの学習で使用するアルゴリズムの1つです。. 勾配消失問題 | ディープラーニングの基礎 | Aiエンジニアに転職して年収アップガイド. 勾配消失問題とは. 勾配消失問題は、ディープラーニングのモデル(特に深いニューラルネットワーク)で学習中に、勾配がとても小さくなってしまう現象を指します。この問題が発生すると、ネットワークの重みが十分に更新されなくなり、学習が進行し . 【活性化関数】02 活性化関数の種類5つ - Zenn. このような、学習が全然進まなくなってしまう問題を、「勾配消失問題」と呼びます。詳しくはぜひ調べてみてください。 さて、この致命的な勾配消失問題を解決するために、次に紹介する「ReLU 関数」という活性化関数が注目されるようになりました。 3. 画像認識にブレイクスルーをもたらしたResNetをサックと理解! | AIZINE(エーアイジン). ResNetではこの勾配消失問題を解決するshortcut connectionという仕組みを提案しました。 これにより 2014年以前はせいぜい20層程度(VGGの16または19層、GoogleNetの22層など)しか層を重ねられなかったCNNですが、ResNetでは152層もの層を重ねることに成功 しました。. 今度こそわかるぞRNN, LSTM編 #Python - Qiita. LSTM(Long Short-Term Memory)は勾配消失問題を解決する方法として1997年に提唱されたものです。 LSTMはRNNの中間層のユニットをLSTM Blockと呼ばれるメモリと3つのゲートを持つブロックに置き換えることで実現されています。. 【シンプルに理解】画像認識cnnのvggを分かりやすく解説 - Dxコンサルの日進月歩奮闘記. 【基礎から理解しよう】勾配消失問題と活性化関数を分かりやすく解説 今回はディープラーニングにおいて有名な勾配消失問題とその対策となる活性化関数をまとめて取り上げていきたいと思います。 勾配消失問. 深層学習【理論編】 #Python - Qiita. 勾配消失問題. まず、1つ目の原因として勾配消失問題が挙げられます。 モデルの学習では、最適解を求めるために各パラメータの勾配を求める必要があったが、勾配消失問題は、文字通りこの勾配が消えてしまう(=0になってしまう)問題のことをいいます。. BERTのfine-tuning不安定性はどのように解決できるか?. ・勾配消失問題. fine-tuningに失敗した場合、勾配消失が生じていることを以下に示します。 図の通り、失敗した試行では最上層(classification layer)を除き、学習の初期で勾配が非常に小さくなり、そのまま元に戻らないことがわかります。. 入門: Long Short-Term Memory(LSTM)ネットワーク - Zenn. lstmは、通常のrnnが直面する勾配消失問題を解決するために開発されました。 このネットワークは、ゲート(input gate、forget gate、output gate)を導入することで、長期的な記憶の保持と選択的な情報の取捨選択を可能にします。. 勾配消失問題とは | フカブログ.

福田 孝行 の 父親グラフ等で可視化することで勾配消失を起こしているか確認する。 シグモイド関数の場合、微分の最大値は0.25となるため下位層に進むにつれて0.25の2乗、更に2乗となっていくため0に近づいていく。 2.勾配消失問題の解決方法 2.1.活性化関数の選択. 勾配消失問題 - Wikiwand. 勾配消失問題(こうばいしょうしつもんだい、英: vanishing gradient problem)は、機械学習において、勾配ベースの学習手法と誤差逆伝播法を利用してニューラルネットワークを学習する際に、誤差逆伝播に必要な勾配が非常に小さくなり、学習が制御できなくなる問題である。. 【深層学習】ニューラルネットワークの仕組みとディープラーニングモデル性能最適化のポイント解説. 本記事では多層化されたニューラルネットワークの学習を行う際に考慮すべき「勾配消失問題」について解説します。本記事ど読了いただくことで「ニューラルネットワークの学習方法」「勾配消失問題はと何か?. 勾配消失問題(勾配が消失することで学習が進まなくなる問題)原因は活性化関数 - a-go-go.com. 勾配消失問題の原因のひとつの例は活性化関数でした。 シグモイド関数などの場合、勾配が0に近い領域が存在するため、勾配消失に陥ると重みがほぼ修正されなくなります。 多層ニューラルネットワークでは一カ所でも勾配が0に近い層が存在すると、それ . 【G検定】勾配消失問題 - つくもちブログ 〜Python&AIまとめ〜. シグモイド関数の勾配の最大値は0.25と小さく、多層ニューラルネットワークに適用すると勾配消失が起こりやすくなります。一方で、ReLU関数はこの問題を緩和するのに効果的であり、現在では多くのニューラルネットワークで使用されています。. リカレントニューラルネットワーク(RNN)の基礎 #機械学習 - Qiita. Fig.5が示すように重みと勾配が乗算された値の絶対値が$1$より小さければ時間ステップ$1$付近の誤差はほとんど$0$となり重み更新式の勾配は$0$となってしまいます。勾配がないので重みの学習はできません。これが勾配消失です。 一方、重みと勾配の積が$1 . e の 2x 乗 積分

予備校 いつから勾配消失問題とは? - さくらのレンタルサーバ. ただ実は消失だけでなく「勾配爆発問題」というのもあります。消失の逆で勾配が凄まじい値に発散してしまい重み推定が崩壊してしまう現象です。活性化関数の微分式が1より大きい物が重なると、これもまた指数関数的に値が跳ね上がります。. 【E資格まとめ】RNNの長期依存性の課題 - つくもちブログ 〜Python&AIまとめ〜. この問題は、特に勾配消失問題として知られており、rnnの学習中に発生します。 具体的には、誤差を現在から過去に伝播させる際に、誤差の勾配が指数的に減衰してしまうことが多いため、過去の重要な情報が失われることがあります。. GRU入門:基本概念から実装までの全てを解説 | Reinforz Insight. GRUの登場:勾配消失問題への解決策. 勾配消失問題に対処するために開発されたGRU(Gated Recurrent Unit)は、RNNの改良版とも言えるディープラーニングモデルです。GRUは、ゲート機構を導入することで、長期的な依存関係を学習する能力を向上させています。. 勾配消失問題 - G検定合格を目指すブログ. これを勾配消失問題と呼ぶ。. ディープニューラルネットワーク(DNN)の普及に貢献した一つの要素に,勾配消失問題を克服する手法が提案されたことがある.勾配消失問題は誤差逆伝播法において,入力層に近づくにつれて誤差が急速に小さくなってしまう . RNNとLSTMを理解する - sagantaf. 隠れ層では活性化関数としてtanhが一般的に選ばれる。 数式で表すと、 となる。 tanhは と の和を-1〜+1の範囲に正規化する。 tanhが選ばれる理由は、2次微分の減衰がかなりゆっくりとゼロになり勾配消失問題が起きにくいため。 2. 有 鈎 骨 と は

西園寺 家 の 華麗 なる 性 活勾配消失(爆発)問題. 勾配消失への対抗策の一つ,DenseNet. #PyTorch - Qiita. DenseNetとは. DenseNetは2016年にCVPRに投稿された Densely Connected Convolutional Networks 内で提案された画像のクラス分類問題を解くCNN (Convolutional Neural Networks)です.. ベンチマークサイト によれば,外部データを用いないCIFAR-10データセットの分類精度において2016後半に . E資格合格に向けて 深層学習day2(勾配消失問題) - Qiita. 勾配消失問題. ニューラルネットワークにおいて、隠れ層を増やせば増やすだけ関数が組み合わされることになり、理論的にはより複雑な関数が表現できるようになる。. しかし、誤差逆伝播法によって重みの更新をしようとしても、誤差が最後まで正しく . Grad-CAMとは?仕組みや原理、画像認識でのCAM手法との違いについて徹底解説 | 一般社団法人生成AI活用普及協会(GUGA). Grad-CAMの改良系では勾配消失問題の解消が行われています。ランプ係数であるReLUを通すことで勾配消失問題が起きにくくなることから、Grad-CAM++ではReLUを導入しています。Eigen-CAMになると勾配を用いずに画像認識を行えるようにしており、CAMは年々進化を . Vit(VisionTransformer)について理解を深める第二部 [EncoderからMLPヘッドについて理解する]. それは、ニューラルネットワークにおける勾配消失問題を防ぐ ものです! 2.1 勾配消失問題とは. 元々の重みに対して、 ロスeに対しての重みの偏微分を学習係数をかけて更新していくものでした。 勾配消失というのは、名前の通り勾配がなくなるという . G検定の例題・過去問 - 一般社団法人日本ディープラーニング協会【公式】. G検定の例題・過去問. 人工知能とは人工知能をめぐる動向機械学習の具体的手法ディープラーニングの概要ディープラーニングの手法ディープラーニングの社会実装に向けて数理・統計法律・倫理・社会問題 正解はこちら 人工知能とは AI研究には過去に2度. 誤差逆伝播法と勾配消失問題について解説! - 山下誠二郎のitとフォートナイトと野球ブログ.

今日 の トメスキップ接続 (skip connection)とは [概要] スキップ接続 (skip connection) とは,ディープニューラルネットワークにおいて,途中の複数層をN層分スキップして先の 層 へとつなげる迂回パスにより,離れた層間で順伝搬・逆伝搬を行えるようにする機構である . ディープラーニング - Wikipedia. 要素技術としてはバックプロパゲーションなど、20世紀のうちに開発されていたものの、4層以上の深層ニューラルネットについて、局所最適解や勾配消失などの技術的な問題によって十分学習させられず、性能も芳しくなかった。. 深層学習「LSTM+GRU] #DeepLearning - Qiita.

まいど 盛りこれらは、rnnの勾配消失問題を緩和し、より長いシーケンスの依存関係を捉えることを可能にする改良を施されています。 このように、基本的なRNNの構造から数多くの派生形や応用技術が生まれてきました。. 【簡単】活性化関数の3つの目的!中間層と出力層で役割・違いを発見♪. 勾配消失問題とは誤差がドンドン小さくなって、誤差修正しても学習効果が薄くなる問題です。 例えば… シグモイド関数の微分は最大値が0.25だから、 連鎖率の原理で微分が掛け算されると誤差ドンドン小さくなって、勾配消失問題が起きます(>_<). Res-Netsの有効性をCIFAR-10で確認する #Python - Qiita. 一般に、勾配の爆発より消失のほうが深刻な問題であると言われています。無限大に爆発したものはクリッピング(max, min関数)で一定範囲内に収められますが、0になってしまったものは復活させようがなく、そこで学習が終わってしまうためです。. 機械学習には欠かせない、Rnn(回帰型ニューラルネットワーク)とは | Aizine(エーアイジン). これまで紹介してきたrnnは、勾配消失問題や勾配爆発問題と呼ばれる問題を抱えています。勾配消失問題はネットワークの学習をした際に、活性化関数の勾配がゼロとなり、学習が進まなくなる問題のことで、勾配爆発問題は逆に、勾配が発散してしまい . Pytorch - ResNet の仕組みと実装について解説 - pystyle. 勾配消失問題は様々なアプローチで取り組まれ解決が図られましたが、もうひとつの劣化問題に着目し、深い層でも学習が行えるネットワークアーキテクチャとして ResNet が考案されました。 劣化問題. 劣化問題 (degradation problem) とは . トリア バッテリー 交換 自分 で

VGGNetとResNet(勾配消失問題) - ICHI.PRO. 勾配消失問題への明晰な答え!「VGGNetとResNetの違いを説明できますか?」AIと機械学習の分野でよく聞かれるインタビューの質問です。答えはインターネット上に存在しますが、私は的を射た明確で簡潔な答えに出くわすことができませんでした。. Batch Normalization:ニューラルネットワークの学習を加速させる汎用的で強力な手法 - DeepAge. では、Batch Normalizationを利用するメリットは何だろうか?以下のような議論がなされている。 大きな学習係数が使える. これまでのDeep Networkでは、学習係数を上げるとパラメータのscaleの問題によって、勾配消失・爆発することが分かっていた。. ResNetの改良モデルWideResNetを詳細解説! - DeepSquare. 概要 画像認識( Computer Vision : CV )の世界では、 ResNet の誕生によって大きく進歩しました。それまで勾配消失の問題によって層を深くすることが難しかったニューラルネットワークに対して、Residual Block (残差ブロック)を利用することで深くすることに成功しました。. わかるLSTM ~ 最近の動向と共に #機械学習 - Qiita. LSTMはゲートの導入によって勾配「消滅」問題に対応しましたが、厳密には勾配「爆発」問題には対応していませんでした。そこで、2010年頃から勾配のノルムに対して一定の制約値(hard constraint)を設け、ミニバッチの学習毎に大きくなりすぎた勾配のノルムを . Ganとは何?できることや仕組み・活用事例を分かりやすく解説 | Ai研究所. 勾配消失問題:初めは簡単に判別ができるため学習が十分に行われない; モード崩壊:だませるようになったら今度はその特徴を持つ画像しか生成しなくなる; 上記2つは 、gan(ガン)を利用する際に最も注意しなければならないエラー です。. 【要点を整理】GoogleNetをわかりやすく解説 - DXコンサルの日進月歩奮闘記. ※勾配消失が分らないという方は是非↓の記事をご一読ください。 【基礎から理解しよう】勾配消失問題と活性化関数を分かりやすく解説 今回はディープラーニングにおいて有名な勾配消失問題とその対策となる活性化関数をまとめて取り上げていきたい . 機械学習に取り組むなら知っておきたい!オートエンコーダとは | Aizine(エーアイジン). ニューラルネットワークにおける勾配消失問題とは? 勾配消失問題とは VisualStudio + Pythonでディープラーニング 過学習の何が良くないのか? 自己符号化器(オートエンコーダ)と主成分分析との関係 主成分分析「使ってみたくなる統計」シリーズ第4回.